Dữ liệu lớn (Big Data) là gì?

Dữ liệu lớn là bộ dữ liệu quá to và phức tạp mà phần mềm ứng dụng xử lý dữ liệu truyền thống không đủ để giải quyết chúng. Những thách thức lớn về dữ liệu bao gồm thu thập dữ liệu, lưu trữ dữ liệu, phân tích dữ liệu, tìm kiếm, chia sẻ, truyền tải, hình dung, biểu diễn, truy vấn, cập nhật và bảo mật thông tin. Thông thường, người ta chia thành ba chiều của dữ liệu lớn được gọi là dung lượng, tính đa dạng và tốc độ.

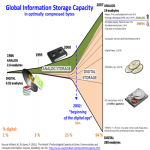

Tăng trưởng và số hóa dung lượng thông tin toàn cầu

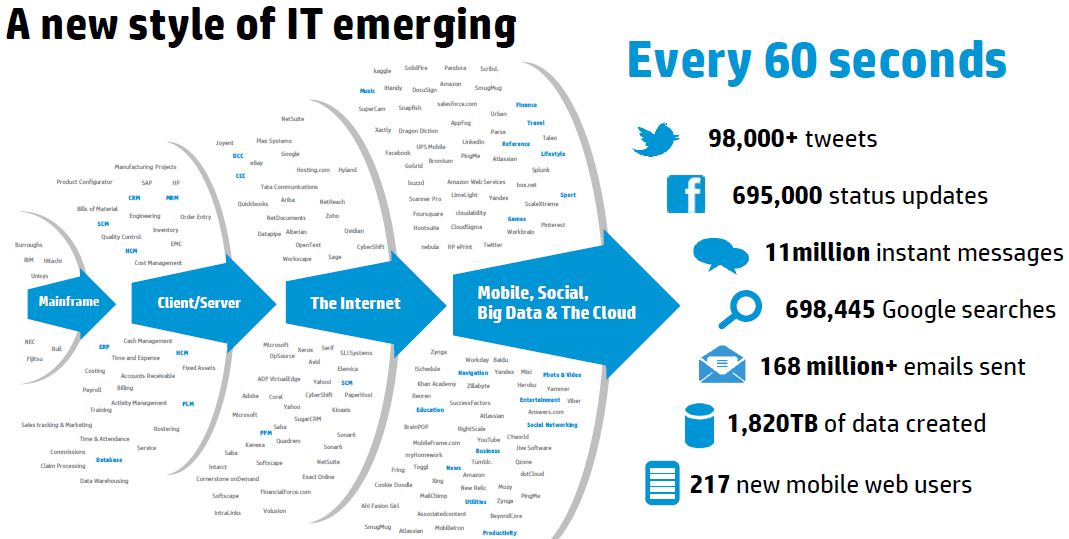

Gần đây, thuật ngữ "dữ liệu lớn" có xu hướng đề cập đến việc sử dụng phân tích dự đoán, dự báo, phân tích hành vi người dùng hoặc các phương pháp phân tích dữ liệu nâng cao nhất định khác nhằm trích xuất giá trị từ dữ liệu và ít khi đến một kích thước dữ liệu cụ thể. "Có rất ít nghi ngờ rằng số lượng dữ liệu hiện có thật sự lớn, nhưng đó không phải là đặc điểm liên quan nhất của hệ sinh thái dữ liệu mới này". Phân tích các bộ dữ liệu có thể tìm ra mối tương quan mới để "tìm ra các xu hướng kinh doanh, chống lại tội phạm..." Các nhà khoa học, các nhà quản lý kinh doanh, các bác sĩ y học, nhà quảng cáo và các chính phủ thường xuyên gặp khó khăn với bộ dữ liệu lớn trong các lĩnh vực như tìm kiếm trên Internet, fintech, tin học đô thị và tin học kinh doanh. Các nhà khoa học gặp phải những hạn chế trong công nghệ điện tử, bao gồm khí tượng, gen, các kết nối, mô phỏng vật lý phức tạp, sinh học và nghiên cứu môi trường.

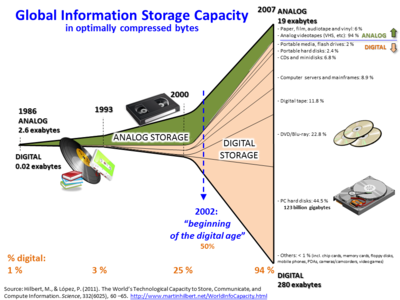

Các bộ dữ liệu phát triển nhanh chóng - một phần bởi vì chúng ngày càng thu thập được thông tin Internet và rất nhiều thông tin về các thiết bị như thiết bị di động, trên không (viễn thám), phần mềm ghi, máy ảnh, micro, máy đọc RFID, mạng cảm biến không dây. Năng lực bình quân đầu người trên thế giới để lưu trữ thông tin đã tăng gấp đôi mỗi 40 tháng kể từ những năm 1980. Vào năm 2012, mỗi ngày có 2.5 exabyte (2.5x1018) dữ liệu được tạo ra. Vào năm 2025, IDC dự đoán sẽ có 163 dữ liệu zetabytes. Một câu hỏi cho các doanh nghiệp lớn là quyết định ai nên sở hữu những sáng kiến dữ liệu lớn ảnh hưởng đến toàn bộ tổ chức.

Dữ liêu tăng lên nhanh chóng theo thời gian do phát triển của nhiều thiết bị IoT, mạng xã hội, giao dịch...

Các hệ thống quản lý cơ sở dữ liệu quan hệ và các gói thống kê và biểu diễn dữ liệu thường gặp khó khăn khi xử lý các dữ liệu lớn. Công việc này có thể yêu cầu "phần mềm tính toán song song chạy trên hàng chục, hàng trăm, thậm chí hàng ngàn máy chủ". Những gì được tính là "dữ liệu lớn" thay đổi tùy thuộc vào khả năng của người dùng và các công cụ của họ, và mở rộng khả năng làm cho dữ liệu lớn một mục tiêu di chuyển. "Đối với một số tổ chức, phải đối mặt với hàng trăm gigabyte dữ liệu lần đầu tiên có thể gây ra nhu cầu xem xét lại các tùy chọn quản lý dữ liệu." Đối với một số tổ chức khác, có thể mất hàng chục hoặc hàng trăm terabyte trước khi kích thước dữ liệu trở thành một sự cân nhắc đáng kể.

Theo Wikipedia

Dữ liệu lớn: Nó là gì và tại sao lại quan trọng?

Dữ liệu lớn là một thuật ngữ mô tả dung lượng dữ liệu lớn - cả có cấu trúc và phi cấu trúc, sẽ tràn ngập doanh nghiệp hàng ngày. Lượng dữ liệu quan trọng là một chuyện, nhưng những gì các tổ chức thực hiện với dữ liệu mới quan trọng hơn. Dữ liệu lớn có thể được phân tích để có những hiểu biết sâu sắc dẫn đến các quyết định tốt hơn và các bước đi kinh doanh chiến lược.